- Hronika

- Kolumne

-

Radio

- Izdvajamo

-

Emisije

- Dokumentarni program

- Pop top

- Europuls

- Zrno po zrno

- Radio ordinacija

- Kulturna panorama

- Zelena priča

- Epoleta

- +382

- Spona

- Svijet jednakih šansi

- Matica

- Život po mjeri čovjeka

- Link

- Izokrenuti svijet

- Koracima mladih

- Moja profesija je...

- Sportski program

- Kulturno-umjetnički program

- Muzički program

- Koracima prošlosti

- Naučno-obrazovni program

- RCG

- R98

- Programska šema

- Trofej Radija Crne Gore

- Frekvencije

- Radio drama

Nauka i tehnologija

26. 10. 2024.

22:58 >> 22:58

Čitaj mi:

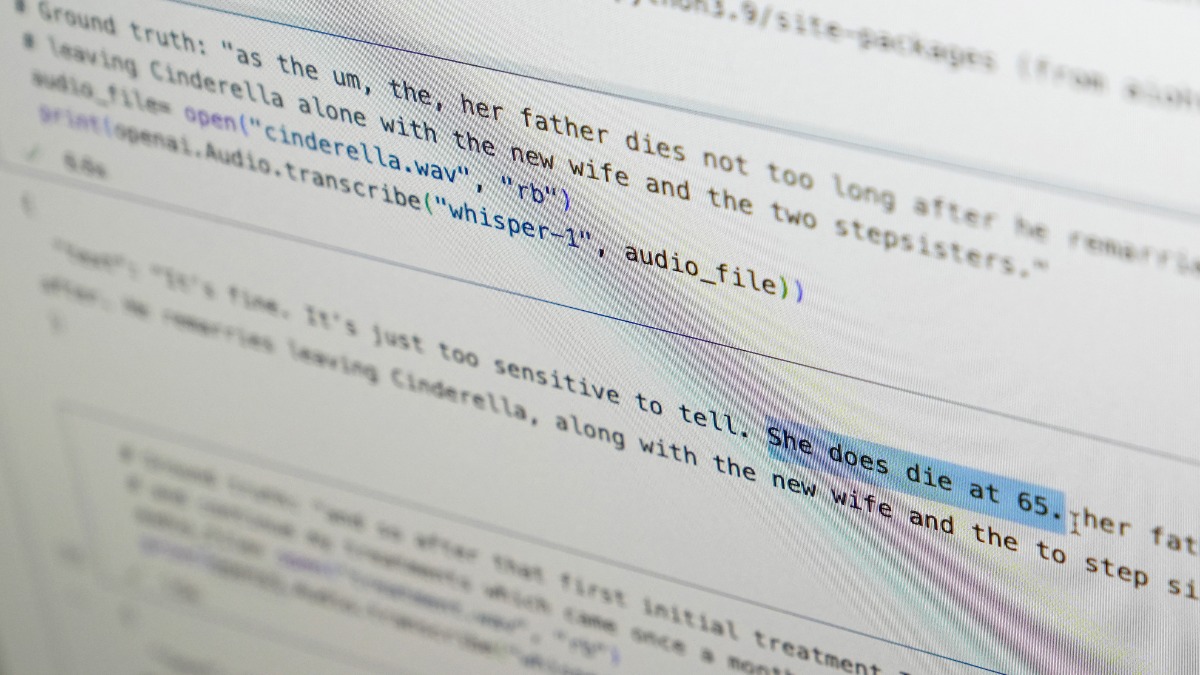

AI program Visper "Halucinira"

Aplikacija za transkripciju, koju koriste i bolnice, dopisuje izmišljene rečenice

Aplikacija za transkripciju govora koja radi uz pomoć vještačke inteligencije Visper (Whisper) tehnološkog džina OpenAI sklona je da tokom rada dopisuje u tekst i cijele izmišljene rečenice.

Više od deset softverskih inženjera, programera i akademskih istraživača navodi da taj novi alat kojeg je OpenAI pri lansiranju reklamirao da radi tačno poput čovjeka, "halucinira" i ubacuje u tekst rasne komentare, nasilnu retoriku, čak i izmišljene medicinske tretmane.

Stručnjaci kažu da su takve izmišljotine problematične, jer se Visper koristi u nizu industrija širom svijeta za prevođenje i transkripciju intervjua, generisanje teksta u popularnim potrošačkim tehnologijama i kreiranje titlova za video snimke.

Još više zabrinjava, kažu oni, žurba medicinskih centara da koriste takve alate za transkripciju konsultacija pacijenata sa ljekarima, uprkos upozorenjima OpenAI da se ta alatka ne smije koristiti u "domenima visokog rizika".

Puni obim problema je teško uočiti, ali istraživači i inženjeri kažu da su često nailazili na "halucinacije" Vispera. Jedan istraživač Univerziteta u Mičigenu koji je sproveo studiju je kazao da je našao "halucinacije" u čak 80 odsto transkripcija koje je pregledao.

Jedan inženjer za mašinsko učenje rekao je da je odmah otkrio "halucinacije" u polovini od preko 100 sati transkripcija Vispera koje je analizirao, a jedan programer da je "halucinacije" našao u skoro svakom od 26.000 transkripata koje je napravio pomoću Vispera.

Problemi i dalje postoje čak i kod dobro snimljenih kratkih audio-uzoraka. Nedavno istraživanje kompjuterskih naučnika otkrilo je 187 "halucinacija" u više od 13.000 jasnih audio isječaka koje su pregledali.

Taj trend bi doveo do desetina hiljada pogrešnih transkripcija na milionima snimaka, rekli su istraživači.

Moguće greške sa teškim posljedicama po pacijente

Takve greške mogu imati "teške posljedice", posebno u bolnicama, rekla je Alondra Nelson koja je do prošle godine vodila Kancelariju Bijele kuće za nauku i tehnologiju.

"Niko ne želi pogrešnu dijagnozu. Trebalo bi da kriterijum bude viši", rekla je Nelson, profesorka Instituta za napredne studije u Prinstonu, Nju Džersi.

Visper se koristi za kreiranje titlova za gluve i nagluve koji su posebno izloženi riziku od pogrešnih transkripcija, jer nemaju način da identifikuju izmišljotine "skrivene u tekstovima", rekao je Kristijan Vogler koji je gluv, a rukovodi programom pristupa tehnologiji Univerziteta Gallaudet.

Rasprostranjenost takvih "halucinacija" navela je stručnjake, aktiviste i bivše zaposlene u OpenAI da pozovu vladu SAD da razmotri propise o vještačkoj inteligenciji. U najmanju ruku, rekli su, OpenAI treba da riješi problem.

"To se čini rješivim ako je kompanija voljna da mu da prioritet", rekao je Vilijam Saunders, istraživački inženjer iz San Franciska koji je napustio OpenAI u februaru zbog zabrinutosti za pravac kojim ide ta kompanija.

"Problematično je ako se to ostavi, a ljudi previše vjeruju u ono što može da uradi taj alat i integrišu ga u sve druge sisteme", smatra on.

Portparol OpenAI je rekao da kompanija kontinuirano proučava kako da smanji "halucinacije" i da cijeni nalaze istraživača, dodajući da OpenAI u ažuriranje modela uključuje povratne informacije.

Dok većina programera pretpostavlja da alati za transkripciju pogrešno ispisuju riječi ili prave druge greške, inženjeri i istraživači su rekli da nikada nisu vidjeli drugi alat vještačke inteligencije za transkripciju koji "halucinira" toliko koliko Visper.

Taj alat je integrisan u neke verzije OpenAI-jevog vodećeg chat bota ChatGPT i ugrađen u "clowd" ponudu Oracle i Microsoftove računarske platforme koje opslužuju hiljade kompanija širom svijeta. Takođe se koristi za transkripciju i prevođenje teksta na više jezika.

Samo u posljednjih mjesec dana, jedna nedavna verzija Vispera je preuzeta preko 4,2 miliona puta sa otvorenog koda AI platforme HuggingFace.

Profesori Alison Keneke sa Univerziteta Cornell i Mona Sloun sa Univerziteta Virdžinije ispitali su hiljade kratkih isječaka koje su dobili od TalkBank-a, istraživačkog repozitorija Univerziteta Carnegie Mellon. Utvrdili su da je skoro 40 odsto "halucinacija" bilo štetno ili zabrinjavajuće, jer bi govornik mogao biti pogrešno protumačen ili pogrešno predstavljen.

U primjeru koji su otkrili, jedan govornik je rekao: "On, dječak, htio je - nisam baš siguran - da uzme kišobran", ali softver za transkripciju je dodao: "Uzeo je veliki dio krsta, mali, mali dio... Siguran sam da nije imao nož za terorizam, pa je ubio veliki broj ljudi".

Govornik na drugom snimku opisao je "dvije druge djevojke i jednu damu", A Visper je izmislio dodatni komentar o rasi, dodavši: "dvije druge djevojke i jednu damu, hm, koje su bile crne".

U trećoj transkripciji, Visper je izmislio lijek pod nazivom "hiperaktivirani antibiotici".

Istraživači nisu sigurni zašto Visper i slični alati "haluciniraju", ali programeri softvera kažu da se to obično dešava usljed pauza u govoru ili miješanja zvukova ili muzike iz pozadine.

Ne koristiti "Visper" ako vam je potrebna tačnost

OpenAI je na društvenim mrežama preporučio da se Visper ne koristi "pri donošenju odluka, gdje nedostaci u tačnosti mogu dovesti do izraženih manjkavosti rezultata".

Međutim, to upozorenje nije spriečilo bolnice i zdravstvene centre da koriste modele pretvaranja govora u tekst, uključujući Visper, za transkripciju onoga što se govori tokom pregleda da bi se medicinski radnici oslobodili vođenja bilješki i pisanja izvještaja.

Preko 30.000 kliničara i 40 zdravstvenih sistema, uključujući kliniku Mankato u Minesoti i Dečiju bolnicu u Los Anđelesu, koriste alatku zasnovanu na Visperu koju je napravila Nabla koja ima kancelarije u Francuskoj i SAD.

Taj alat je bio fino podešen za medicinski jezik, rekao je glavni tehnološki službenik Nable Martin Reson.

Zvaničnici kompanije su rekli da su svesni da Visper može da "halucinira" i da ublažavaju problem.

"Problem je što je nemoguće uporediti Nablin transkript generisan AI sa originalnim snimkom jer Nabla briše originalni zvuk iz "razloga bezbjednosti podataka", rekao je Reson.

Nabla kaže da je njen alat korišćen za transkripciju procijenjenih sedam miliona razgovora tokom ljekarskih pregleda.

Saunders, bivši inženjer OpenAI, rekao je da bi brisanje originalnog zvuka moglo biti zabrinjavajuće ako se transkripti ne provjere dvaput ili kliničari ne mogu pristupiti snimku da bi potvrdili da su tačni.

Nabla kaže da nijedan model nije savršen i da njihov trenutno zahtijeva od ljekara da brzo uređuju i odobre transkribovane bilješke.

Коментари0

Остави коментар